目前華碩集團的 AI 人才規模約達千人以上,除了致力於研發各類 AI 相關硬體,包括 AI 伺服器、AI PC、AI 手機及各類 IoT 裝置,更全力打造由雲端、地端到邊緣運算所需的軟體架構及解決方案,為臺灣打造下一個世界級領導產業。

採訪/林振輝、施鑫澤·文/林裕洋·刊期/2024.07

生成式 AI 浪潮席捲全球,被譽為是支撐 21 世紀發展的重要動能。根據 Coursera 公布研究報告指出,2024 年有 89% 企業將 AI、生成式 AI 等列為技術優先事項之一,然而有 2/3 企業對相關技術發展感到不滿意,關鍵在於缺乏相關 AI 人才和技能。儘管目前沒有明確數字,不過隨著愈來愈多企業表明有意願推動 AI 專案,預估人才缺口可達到數百萬以上。

日前公開對外表示將抓住本次 AI 革命契機,全力朝向全方位 AI 公司的華碩電腦,早在 2016 年即著手佈局 AI 市場。目前華碩集團的 AI 人才規模約達千人以上,除了致力於研發各類 AI 相關硬體,包括 AI 伺服器、AI PC、AI 手機及各類 IoT 裝置,更全力發展由雲端、地端到邊緣運算所需的軟體架構及解決方案,不僅打造出 AI 超級電腦,更利用運用大語言模型,加速落實生成式 AI,為臺灣打造下一個世界級領導產業。

華碩電腦雲端架構軟體中心協理兼台智雲技術長陳忠誠表示,副董事長徐世昌在 2016 年即提出要朝向 AI、雲端發展,並且開始籌組相關團隊。2018 年當時的科技部為滿足臺灣 AI 中心的發展需求,提出打造臺灣杉二號計畫,打造 AI 算力平台,此計畫也成為我們與政府合作的第一個案例。在現今 AI 算力當道趨勢下,很佩服當時陳良基部長的遠見,讓臺灣杉二號成為臺灣產業發展 AI 的重要後盾。

臺灣杉二號由 252 個節點組成,每個節點包含 2 顆 CPU 及 8 顆 GPU,其主機架構設計與國際趨勢同步。在科學家運用大數據進行深度學習時,可表現出更優質的性能;此外,在節能方面,臺灣杉二號能源效率達 11.285 GF/W,計算量在 9 PFLOPS 時用電 798 KW,亦為臺灣史上最節能的高速計算主機。

成立台智雲 正式對產業界提供服務

臺灣杉二號初期由國網中心進行維運,主要為學界的研究專案提供服務。隨著行政院推動 AI 產業化與產業 AI 化的政策,2021 年華碩電腦正式成立台智雲,對產業提供服務。

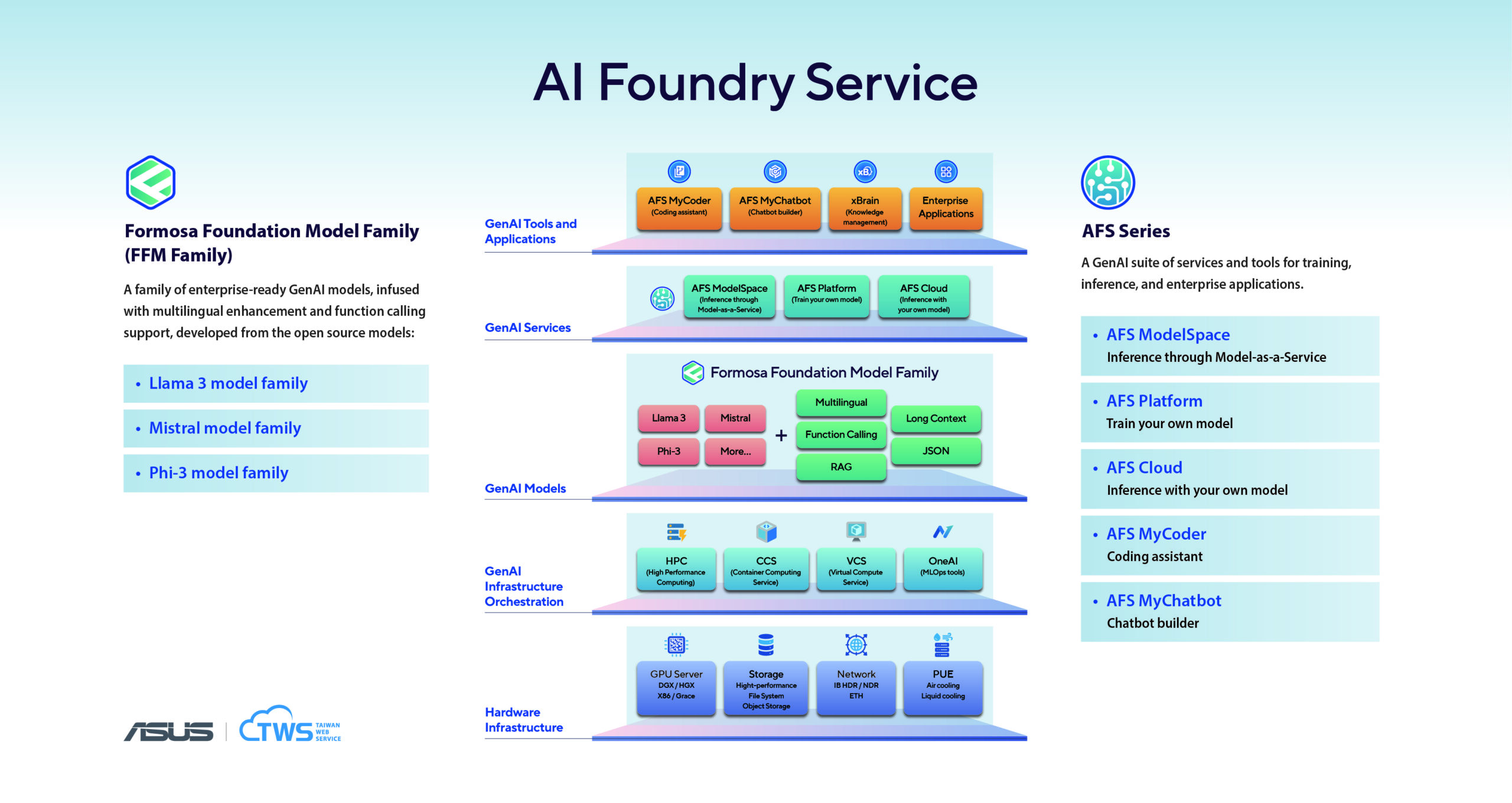

透過 AIHPC 雲平台提供 AI 模型代工服務(AI Foundry Service),將 AI 服務業的模式形塑成商業化發展 AI Foundry,每間企業不一定需要有自己的 AI 研發團隊,也可以導入 AI 應用和服務。就如同現今晶片設計公司仰賴晶圓半導體代工的製造服務,不需自建工廠和產線,台智雲也將以 AIHPC 雲服務方式提供高效算力與資安解決方案,協助客戶同時擁抱兼顧智慧與信任的數位大未來。

陳忠誠指出,其實,華碩在 AI、自然語言耕耘多年,從投入 AI 領域開始,我們透過一路學習、累積經驗的方式,開發 AI 的應用,2018 年跨入 AI 資料中心的設計建置,同時累積 7×24 小時商業運營能力等等,為下一代 AI 計算累積了寶貴的經驗及基礎。

[ 熱門精選:藉助 AI,私有雲捲土重來 ]

華碩雲端暨台智雲總經理吳漢章指出,事實上早在 2022 年底 ChatGPT 正式問世之前,我們透過與 NVIDIA、業界夥伴之間的交流,就知道大語言模型即將來臨。由於華碩集團投入 AI 領域多時,累積非常豐富的經驗與技術能力,所以我們才能在 2023 年 5 月以 BLOOM 基礎模型為核心,推出臺灣首個繁體中文大語言模型 —「福爾摩沙大模型」(Formosa Foundation Model)。

這是運用臺灣杉二號超級電腦建立的臺灣第一個高達 1,760 億(176B)參數的大型語言模型,規模與 GPT-3.5 模型類似,並強化繁體中文、貼近臺灣用語和知識,且更新至 2022 年的資料。結合華碩專為企業客戶打造的生成式 AI 基礎架構,能夠控制資料的時效性,消除企業機密外洩的風險。

技術團隊結合 AIHPC 平台

擴大福爾摩沙大模型產品線

繼推出以 BLOOM 為核心的福爾摩沙大模型外,台智雲又持續針對 Llama2、Mistral、Llama3 等基礎模型,進行繁體中文訓練工作,擴大福爾摩沙大模型的產品項目,提供各式開源模型之繁中強化版本。

在模型規格方面,也提供各模型最完整之參數量規格,包括 BLOOM-176B、Mixtral-8x7B、Llama3-70B 等巨量參數大模型,可滿足不同產業客戶的運用需求。在最完整多樣的大語言模型規格之外,台智雲也運用華碩電腦在 AI 伺服器、AI 資料中心的優勢,推出整合軟體、硬體、顧問服務的一站式方案,加速企業 AI 2.0 落地應用。

[ 加入 CIO Taiwan 官方 LINE 與 Facebook ,與全球 CIO 同步獲取精華見解 ]

「台智雲能領先其他業者推出繁體中文化的福爾摩沙大模型,乃至於推出一站式解決方案,關鍵在於擁有非常完整的 AI 基礎架構與團隊。我們擁有全臺灣算力最強的 AIHPC 平台,及有實戰經驗的 AI 團隊,這都是其他業者沒欠缺的優勢。」吳漢章解釋:「在前述種種優勢下,我們才能把福爾摩沙大模型變成服務,企業可直接在雲端平台使用該服務,也能將該 AI 模型落地到企業之中,並透過 API 與公司內部應用程式整合,滿足多人共用的情境,成功扮演提升員工工作效率的助手。」

臺灣杉二號 GPU 利用率達 40%

超越 OpenAI GPT-3 模型

在生成式 AI 浪潮下,帶動各種開源基礎大語言模型如雨後春筍般的出現,也讓大語言模型成為多數人朗朗上口的名詞。

然而,要訓練大語言模型是非常困難工作,除必須要事先準備大量資料之外,也會面臨單一 GPU 晶片無法載入大量資料量的困擾,因此必須透過資料分割給多張 GPU 卡計算,最後再進行合併的工作。然以現今電腦架構來看,每台 AI 主機能安裝的 GPU 卡數量有限,如何妥善資料分配給多台 AI 伺服器進行運算,並且讓 GPU 卡發揮最大效益,是件不容易克服的挑戰。

[ 熱門精選:專訪國立陽明交通大學資訊學院副院長陳添福教授 ]

陳忠誠說,在大語言模型訓練過程中,GPU 利用率 MFU(Model FLOPS Utilization)是非常重要的指標。現今 GPU 晶片運算能力非常強大,企業必須思考如何將資料塞滿 GPU 晶片的方法,才能發揮 GPU 晶片的最大算力。只是要提升 GPU 利用率的難度非常高,特別是當多台 AI 伺服器協同運作時更不容易。以 Open AI 公佈資料顯示,他們使用相同的 V100 GPU 訓練 GPT-3 模型的利用率大概只有 21%,相較之下我們在臺灣杉二號主機進行訓練時,GPU 利用率可達到 40% 以上,這代表該超級電腦建置初期即考量到大量資料交換需求,採用非常先進的設計模式。

舉例而言,華碩電腦團隊在規劃臺灣杉二號主機時,GPU 卡與 GPU 卡之間採用 NV-LINK 技術,AI 主機之間則使用具備高處傳輸能力的 InfiniBand,至於資料則放在高速的儲存設備進行訓練,搭配平行運算機制等。台智雲能在各種最新開源大語言模型問世時,成為臺灣第一個完成繁體中文化訓練工作的業者,關鍵即在擁有算力,並有熟悉大語言模型訓練的 AI 團隊,自然能在市場中取得領導地位。

Llama2/Llama3 各具特色 台智雲服務多元化

陳忠誠指出,台智雲已完成 Llama2、Llama3 等基礎模型的繁體中文訓練工作。其中,FFM-Llama 2 是全球第一個繁體中文強化版的 Llama 2(70B/13B/7B)全系列模型,採用最新世代原生 Meta Llama 2 大型語言模型為基礎,運用 AIHPC 超級電腦算力、優化的高效平行運算環境、大語言模型切割技術和大量繁體中文語料進行優化訓練。至於 FFM-Llama3 則是基於 Meta-Llama3 以優異繁中語料訓練而成,原生 128K 多語言擴充詞表,具強大推理能力及多元應用場景。此外,還具備原生模型不支援的 Function Calling 功能,快速串接外部資訊拓展全面商業應用,在繁中評測 TMMLU+ 分數超越 GPT-4.0 的繁中語言大模型,創下繁中模型新紀錄。

目前台智雲對客戶主要提供三種服務,首先是提供各種完成繁中訓練的基礎語言模型,讓企業能夠依照營運需選擇合適的 AI 模型。其次,則是針對 AI 人力有限或者嘗試想要推動 AI 專案客戶,提供運用資料針對 AI 模型進行推論、微調及 RAG(Retrieval-Augmented Generation)的服務,讓客戶了解 AI 帶來效益與合適的運用場景。第三種服務則是提供專案所需的 AI 算力,協助客戶在公司內部落地大語言模型,進而達到保護資料隱私、滿足 AI 專案推動需求。

生成式 AI 影響日深

隨著生成式 AI 應用範圍日廣,為企業帶來效益也更明顯。台智雲認為該技術特性將帶來 People、Process、Product、Position 等 4P 運用,不但可讓資料價值提升,是從上到下全面性的影響,將是推動產業新技術前進的火車頭。只是要推動生成式 AI 專案,企業通常會面臨資料量爆炸難以處理、缺乏 AI 預測建模、事件分析因應時程太長等三大挑戰,所幸前述問題現今都能透過台智雲獲得解決。

台智雲新推出的 Predictive GenAI 將洞察 AI 和生成式 AI 結合,解決傳統 ML 面臨的困難,助企業用更快速簡單方式提出問題、優化資料、處理分析,讓營運團隊做出更具洞察力和預測性的判斷。企業自然可達到洞察資料、洞悉市場,強化市場競爭力的目標。

[ 推薦閱讀:專訪凱基證券亞太區資訊長暨資安長黃榮林 ]

吳漢章指出,Predictive GenAI 結合繁體中文化的LLM,可賦能企業洞察決策更深、更廣、更全面,進而理解和洞察時序性資料的趨勢,輕鬆實現只要簡單提問就能即時取得動態的預測洞察分析結果,大幅提升企業決策的靈活彈性。特別是當企業打造數個不同領域專業的 Predictive GenAI,透過 FFM 和 Function Call 串接其他應用軟體,建立更為即時且精確的 FFM BI Knowledge Application,提升業務效率和營收。

華碩電腦建議企業應該加速導入生成式 AI,並藉由外部專家協助克服挑戰,才能在市場上維持領先地位。

(本文授權非營利轉載,請註明出處:CIO Taiwan)