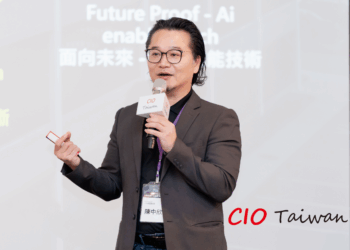

2025 金融科技高峰會秋季場

數位轉型與 AI 浪潮下,金融業積極導入大型語言模型(LLM),卻面臨模型迭代快、資料準備繁瑣、知識綁定等挑戰。翱騰國際科技提出以資料為核心、模型中立、即時落地的敏捷部署策略,協助金融機構突破瓶頸,加速釋放 AI 商業價值。

文/明雲青

隨著數位轉型與 AI 應用迅速擴張,金融業積極探索 LLM 應用潛力,盼以智能化強化營運與服務。然而模型迭代快速、資料準備繁瑣、知識深度綁定單一模型等問題,常導致部署延遲、成本攀升,甚至模型未上線即過時。

翱騰國際科技董事長陳新博士指出,企業應應聚焦「資料標準化」與「知識可攜性」,而非追逐模型更新。資料是長期核心資產,模型僅為可替換的推論引擎。若知識被綁定特定模型,將增加重複建置成本與遷移風險。

對此翱騰提出「資料驅動、模型中立、即時落地」的敏捷部署策略,核心在於資料與模型解耦。透過可觀測與可稽核的閉環訓練管線,企業能快速將知識轉化為價值,兼顧資料主權、合規風險管理、效率提升與客戶體驗增長,推動 AI 應用從單點 PoC 走向規模化營運。

在實務上,陳新博士建議先標準化私有資料,將合規手冊、產品說明、客服紀錄等文件轉換為純文字或 JSON 格式,再進行語意切片、向量嵌入與中繼資料標註,建立可攜式語料庫。如此當新版基礎模型推出時,企業可快速重訓與導入,保留資料價值並縮短部署週期。

[ 加入 CIO Taiwan 官方 LINE 、 Facebook 與 IG,與全球CIO同步獲取精華見解 ]

針對金融業務高度講求時效,建議優先採用 RAG(檢索增強生成)與 RPA(機器人流程自動化)技術,先在真實場景中迅速創造價值,再於後台持續優化。此過程中無須全面重訓模型,而是分析 RAG 使用日誌,針對高頻查詢與低準確回覆的熱點,進行定向增量訓練。此舉可大幅節省算力與時間,讓模型隨著使用者回饋持續進化,實現雙週或每月定期更新,維持技術領先。

目前該策略已在加密資產管控與交叉銷售等金融場景驗證。透過規則偵測結合 LLM 語意推理,不僅加速合規審查,還能累積可追溯證據鏈。同時,AI 數位社群平台則藉由統一入口、自動分流、唯一 ID 追蹤與即時知識庫,有效解決個資分流、獎勵歸屬不明、知識不足與客戶流失等痛點,並促進合規高效的跨部門協作。

另值得一提,翱騰已基於端到端架構藍圖打造 Orion AI Connect 客戶服務平台,兼具創新擴展、整合效率、成本效益、用戶體驗優化與維運簡化等優勢,協助金融機構以 AI 驅動方式實現數位轉型。

(本文授權非營利轉載,請註明出處:CIO Taiwan)